Вычислительный комплекс Hewlett-Packard представляет собой единый компьютерный комплекс, построенный на базе аппаратно-программных решений, предоставленных компанией HP.

В задачи вычислительного комплекса HP (далее — ВК HP) входят услуги по предоставлению:

1. выделенных виртуальных машин для учебно-научных и административно-хозяйственных подразделений Санкт-Петербургского государственного университета (далее СПбГУ);

2. мощностей кластера высокопроизводительных вычислений для работ в области физики, химии, биологии и др.

Структура ВК НР

Кластер облачных вычислений представляет из себя виртуальные хосты, системы хранения данных, сети хранения и передачи данных и программное обеспечение, позволяющие предоставлять услугу временного пользования виртуальных машин с заданными пользователем характеристиками для учебно-научных и административно-хозяйственных подразделений СПбГУ.

Кластер высокопроизводительных вычислений представляет из себя серверы, системы хранения данных, сети хранения и передачи данных и программное обеспечение, позволяющие проводить исследования в области физики, химии, биологии и других наук, требующие мощных вычислительных ресурсов.

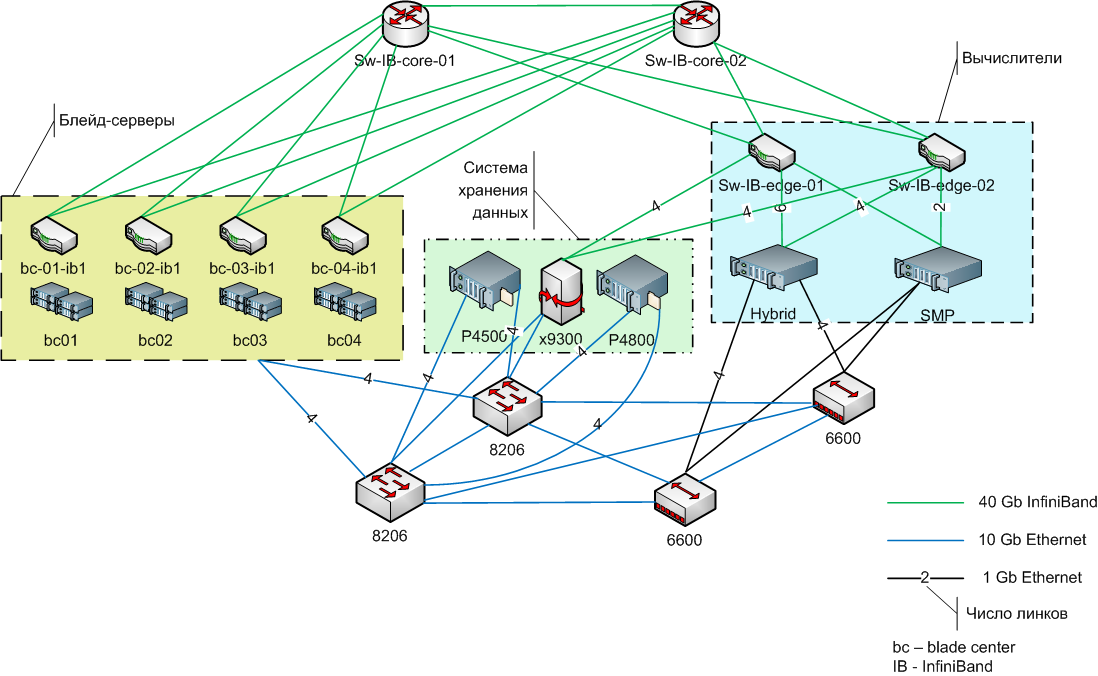

Коммуникационное оборудование представлено коммутаторами, использующими технологии Gigabit Ethernet, 10 Gigabit Ethernet и InfiniBand QDR.

Система хранения данных служит для размещения пользовательских данных, образов виртуальных машин и прочей информации и представляет собой совокупность дисковых массивов, шлюзов и виртуальных библиотек.

На вычислительном комплексе HP развернуты:

- - кластер VMware (blade-серверы);

- - вычислительные кластеры;

- - сетевое оборудование;

- - система хранения данных;

- - система резервного копирования.

Внешний вид вычислительного комплекса HP

Спецификация комплекса

Кластер облачных вычислений состоит из следующих основных компонентов:

- - 4 шасси HP BladeSystem c7000 для установки блейд-серверов;

- - 32 блейд-сервера BL460c G6;

- - 28 блейд-серверов BL460c G7;

- - программная среда VMWare vSphere 5 под управлением гипервизора VMWare ESXi 5, использующая вышеуказанные серверы как хосты для виртуализации;

- - сервер управления виртуализацией VMWare VCenter Server.

Кластер высокопроизводительных вычислений состоит из двух субкластеров: SMP и гибридного.

Субкластер SMP включает:

- - 3 сервера HP ProLiant DL980 G7.

Гибридный кластер включает:

- - 8 шасси s6500 для установки серверов;

- - 16 серверов HP ProLiant SL390s 2U;

- - 8 серверов HP ProLiant SL390s 4U.

Управление кластером высокопроизводительных вычислений осуществляется с головного узла HP ProLiant DL360 G7.

Кластер облачных вычислений и кластер высокопроизводительных вычислений используют следующие общие сети передачи данных:

- - Gigabit Ethernet;

- - 10 Gigabit Ethernet;

- - InfiniBand QDR 4x.

Сетевое оборудование представлено следующими устройствами:

- - 2 коммутатора HP 6600;

- - 2 коммутатора HP 8206;

- - 4 пары соединительных модулей BladeSystem Virtual Connect Flex-10;

- - 4 коммутатора Voltaire 4036;

- - 4 встроенных коммутатора Mellanox для блейд-шасси.

Система хранения данных:

- - дисковый массив P4500 G2;

- - дисковый массив P4800 G2;

- - массив-шлюз x9300;

- - виртуальная библиотека D2D4106i.

Характеристики комплекса

Характеристики кластера облачных вычислений

|

№ |

Наименование |

Количество |

CPU |

RAM |

Адаптеры и модули |

Примечания |

|

1 |

Шасси для блейд-серверов НР BladeSystem c7000 |

4 |

- |

- |

Коммутационные модули Virtual Connect Flex-10 (10 Gb Ethernet) и InfiniBand |

- |

|

2 |

Блейд-сервер BL460c G6 |

32 |

2 х Intel Xeon X5670 3.06 GHz |

96 Gb |

Сетевые интерфейсы 10 Gb Ethernet и InfiniBand |

- |

|

3 |

Блейд-сервер BL460c G7 |

28 |

2 х Intel Xeon X5675 3.06 GHz |

96 Gb |

Сетевые интерфейсы 10 Gb Ethernet и InfiniBand |

- |

Характеристики кластера высокопроизводительных вычислений

Субкластер SMP

|

№ |

Наименование |

Количество |

CPU |

RAM |

Адаптеры и модули |

Примечания |

|

1 |

Сервер НР ProLiant DL980 G7 |

2 |

Intel Xeon X7560 2.2 GHz |

512 Gb/2 Tb |

Адаптеры для доступа к сети Gb Ethernet и InfiniBand |

- |

|

2 |

Сервер НР ProLiant DL980 G7 |

1 |

Intel Xeon X7560 2.2 GHz |

2 Tb |

Адаптеры для доступа к сети Gb Ethernet и InfiniBand |

- |

Гибридный кластер

|

№ |

Наименование |

Количество |

CPU |

RAM |

Адаптеры и модули |

Примечания |

|

1 |

Шасси s6500 |

8 |

- |

- |

- |

- |

|

2 |

HP ProLian SL390s 2U |

16 |

2 х Intel Xeon X5650,3 х nVidia TeslaM 2050 |

96 Gb |

Адаптеры для доступа к сети Gb Ethernet и InfiniBand |

- |

|

3 |

HP ProLian SL390s 4U |

8 |

2 х Intel Xeon X5650,8 х nVidia TeslaM 2050 |

96 Gb |

Адаптеры для доступа к сети Gb Ethernet и InfiniBand |

- |

|

4 |

HP ProLian DL360 G7 |

1 |

2 х Intel Xeon X5650 | 12 Gb | - |

Головной узел кластера высокопроизводительныхвычислений |

Характеристики сетевого оборудования

|

№ |

Наименование |

Количество |

Число портов |

Технология передачи данных |

Примечания |

|

1 |

Коммутатор НР 6600 |

2 |

48 |

Gigabit Ethernet |

|

|

2 |

Коммутатор НР 8206 |

2 |

20 |

10 Gigabit Ethernet |

|

|

3 |

Межсоединительные модули BladeSystem Virtaire Conect Flex-10 |

4 х 2 |

8 |

10 Gigabit Ethernet |

|

|

4 |

Коммутатор Voltaire 4036 |

4 |

- |

InfiniBand QDR 4x |

|

|

5 |

Bстроенные коммутаторы Mellanox |

4 |

- |

InfiniBand QDR 4x |

Производительность (результаты измерений)

Производительность кластера на базе блейд-серверов.

Целью испытаний было определение двух параметров: максимального числа операций с плавающей запятой в секунду (Rmax) и процентного отношения этого числа к теоретической производительности (Rpeak), вычисленной на основе характеристик центральных процессоров, предоставленных производителем.

Получены следующие результаты:

|

Состав кластера |

28 узлов, 56 процессоров, 336 ядер |

|

Операций в секунду (Rmax) |

3618 Гигафлопс |

|

Отношение Rmax/Rpeak |

87,8% |

Технические подробности испытаний

Испытания проводили с помощью теста HPLinpack 2.0, представляющего собой систему линейных алгебраических уравнений, для решения которой применяется метод Гаусса. В ходе вычислений производится большое количество операций с плавающей запятой (floating point operations — FLOP). Количество таких операций в секунду (floating point operations per second — FLOPS, flops, флопс) является оценкой быстродействия процессоров, позволяющей прогнозировать возможности кластера для решения реальных вычислительных задач.

Были проведены следующие измерения:

- тест HPL на одном, двух, четырёх, восьми, шестнадцати и двадцати восьми узлах.

Полученные результаты приведены в таблице ниже. Один шестиядерный процессор Intel Xeon X5675 3.06 GHz даёт производительность 73,584 гигафлопс. В каждом узле установлено по 2 центральных процессора, следовательно, пиковая теоретическая производительность одного узла равна 73,584×2=147,168 гигафлопс. Теоретическая пиковая производительность и отношение Rmax/Rpeak приведены в таблице.

|

Количество Узлов |

Rmax |

Rpeak |

Rmax/Rpeak, % |

|

1 |

133,3 |

147,168 |

90,58 |

|

2 |

265,6 |

294,336 |

90,24 |

|

4 |

529,3 |

588,672 |

89,91 |

|

8 |

1052 |

1177,344 |

89,35 |

|

16 |

2079 |

2354,688 |

88,29 |

|

28 |

3618 |

4120,704 |

87,80 |

Производительность гибридного кластера высокопроизводительных вычислений

Целью испытаний было определение двух параметров: максимального числа операций с плавающей запятой в секунду (Rmax) для шестнадцати узлового гибридного кластера, и процентного отношения этого числа к пиковой производительности (Rpeak), вычисленной на основе характеристик графических и центральных процессоров, предоставленных производителем.

Получены следующие результаты:

|

Состав кластера |

24 узла, 72 графических процессоров, 48 центральных процессоров (288 ядер) |

|

Операций в секунду (Rmax) |

19590 Гигафлопс |

|

Отношение Rmax/Rpeak |

48,79% |

Технические подробности испытаний

Испытания проводили с помощью теста HPLinpack 2.0, аналогично кластеру на базе блейд-серверов.

Были проведены следующие измерения:

- - тест HPL на одном, двух, четырёх, восьми, шестнадцати узлах с тремя графическими процессорами,

- - тест HPL на одном, двух, четырёх, восьми узлах с восемью графическими процессорами,

- - общий тест HPL на 24 узлах с задействованием трёх графических процессоров.

Полученные результаты приведены в таблице ниже. Один графический процессор Tesla M2050 даёт производительность 515 гигафлопс. Один шестиядерный процессор Intel Xeon X5650 2.66 GHz даёт производительность 63,984 гигафлопс. В каждом узле первого типа (2U) установлено по 3 графических процессора, следовательно, пиковая производительность одного узла первого типа (2U) равна 515×3+63,984×2=1672,968 гигафлопс. Аналогично, для узлов второго типа (4U): 515×8+63,984×2=44247,968 гигафлопс. Теоретическая пиковая производительность и отношение Rmax/Rpeak приведены в таблице.

|

Количество узлов |

Rmax | Rpeak | Rmax/Rpeak, % |

|

3 GPU |

|||

|

1 |

1017 |

1672,968 |

60,79 |

|

2 |

1932 |

3345,936 |

57,74 |

|

4 |

3647 |

6691,872 |

54,50 |

|

8 |

7259 |

13383,744 |

54,24 |

|

16 |

13060 |

26767,488 |

48,79 |

|

24 |

19590 |

40151,232 |

48,79 |

|

8 GPU |

|||

|

1 |

2152 |

4247,968 |

50,66 |

|

2 |

4183 |

8495,936 |

49,24 |

|

4 |

8357 |

16991,872 |

49,18 |

|

8 |

16540 |

33983,744 |

48,67 |

|

Общий тест |

|||

|

24 |

19590 |

40151,232 |

48,79 |

Сетевая инфраструктура

Локальная сеть комплекса реализована на базе двух скоростных режимов: 1-гигабитная сеть Ethernet и 10-гигабитная сеть Ethernet.

В состав 1-гигабитной сети входят коммутаторы 8206, 6600 и подключённые к ним устройства – управляющие интерфейсы оборудования (iLO, Onboard Administrator, Management Interface) и узлы кластеров высокопроизводительных вычислений. В состав 10-гигабитной сети входятмодули Virtual Connect Flex-10 и коммутаторы 8206.

Высокоскоростная сеть InfiniBand построена на базе коммутаторов Voltaire 4036 и встроенных коммутаторов Mellanox для блейд-шасси. Сеть построена по технологии InfiniBand 4x QDR. Пропускная способность – 40 Гбит/с. Применена топология «толстого дерева» (fat tree), при которой устройства подключены к периферийным коммутаторам (edge switches), а периферийные коммутаторы соединяются с парой центральных коммутаторов (core switches). Между любой парой коммутаторов «центр-периферия» подключено по 4 межкоммутаторных соединения.

Схема сетевой инфраструктуры ВК НР